Como parte del trabajo de inteligencia artificial responsable de Intel, la empresa ha creado FakeCatcher, una tecnología que puede detectar videos falsos con una tasa de precisión del 96%.

La plataforma de detección de deepfake de Intel es el primer detector del mundo de falsificación profunda en tiempo real que devuelve resultados en milisegundos.

«Los videos deepfake están en todos lados hoy en día.

Probablemente ya has visto alguno; videos de celebridades haciendo o diciendo cosas que realmente nunca han hecho.»

La plataforma en tiempo real de Intel utiliza FakeCatcher, un detector diseñado por Demir en colaboración con Umur Ciftci de la Universidad Estatal de Nueva York en Binghamton.

Utilizando hardware y software de Intel, se ejecuta en un servidor e interactúa a través de una plataforma basada en la web.

Por el lado del software, una orquesta de herramientas especializadas forma la arquitectura optimizada de FakeCatcher.

Los bloques de visión por computadora se optimizaron con Intel® Integrated Performance Primitives (una biblioteca de software de subprocesos múltiples) y OpenCV (un conjunto de herramientas para procesar imágenes y videos en tiempo real), mientras que los bloques de inferencia se optimizaron con Intel® Deep Learning Boost y con Intel® Advanced Vector Extensions 512 y los bloques de medios se optimizaron con Intel® Advanced Vector Extensions 2.

Los equipos también se apoyaron en el proyecto Open Visual Cloud para proporcionar una pila de software integrada para la familia de procesadores Intel® Xeon® Scalable.

En cuanto al hardware, la plataforma de detección en tiempo real puede ejecutar hasta 72 flujos de detección diferentes simultáneamente en procesadores escalables Intel® Xeon® de tercera generación.

La mayoría de los detectores basados ??en el aprendizaje profundo analizan los datos sin procesar para tratar de encontrar signos de falta de autenticidad e identificar lo que está mal en un video.

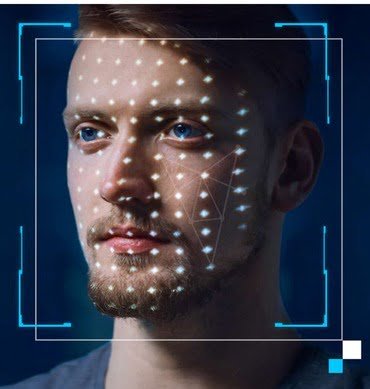

Por el contrario, FakeCatcher busca pistas auténticas en videos reales, evaluando lo que nos hace humanos: un «flujo sanguíneo» sutil en los píxeles de un video.

Cuando nuestro corazón bombea sangre, nuestras venas cambian de color.

Estas señales de flujo sanguíneo se recopilan de todo el rostro y los algoritmos traducen estas señales en mapas espaciotemporales.

Luego, utilizando el aprendizaje profundo, podemos detectar instantáneamente si un video es real o falso.

Los videos deepfake son una amenaza creciente.

Las empresas gastarán hasta $188 mil millones de dólares en soluciones de ciberseguridad, según Gartner.

También es difícil detectar estos videos falsos profundos en tiempo real: las aplicaciones de detección requieren cargar videos para analizarlos y luego esperar horas para obtener resultados.

El engaño debido a las deepfakes puede causar daño y tener consecuencias negativas, como la disminución de la confianza en los medios.

FakeCatcher ayuda a restaurar la confianza al permitir que los usuarios distingan entre contenido real y falso.

Hay varios casos de uso potenciales para FakeCatcher.

Las plataformas de redes sociales podrían aprovechar la tecnología para evitar que los usuarios carguen videos falsos dañinos.

Las organizaciones de noticias globales podrían usar el detector para evitar la amplificación involuntaria de videos manipulados.

Y las organizaciones sin fines de lucro podrían emplear la plataforma para democratizar la detección de deepfakes para todos.

Más contexto: Obtenga más información sobre la investigación de Medios Confiables y sobre el compromiso de Intel con el avance tecnológico de la IA de manera responsable a través de un enfoque multidisciplinario con socios académicos y de la industria.

Únete a Demir mientras se sumerge en la tecnología detrás de FakeCatcher, sus desafíos clave y las oportunidades que presenta Intel y la industria en un evento de Twitter Spaces a las 11:30 a.m. PST el 16 de noviembre.

Nota del editor: esta publicación de noticias se actualizó el 15 de noviembre de 2022 con información para describir mejor la colaboración detrás de FakeCatcher.

Fuente:

https://arxiv.org/pdf/2101.01165.pdf